智能辅助驾驶的「智能」表现,正伴随着新能源汽车渗透率的快速提升而变得日新月异。

在领航辅助驾驶确立了从「有图」到「无图」的技术路线迭代之后,「端到端」成为了智驾领域的新目标。

今年年初,特斯拉推送了首个搭载「端到端神经网络模型」的 FSD v12 Supervised 版本,紧接着包括鸿蒙智行、理想、小鹏在内的一众走在智驾前列的主机厂,都将量产推送「端到端」智驾作为了下半年的重要目标之一。

最近,董车会也在公开道路上,体验了最新的华为 ADS 3.0 的「端到端」智驾表现。

事实上,它的确令人印象深刻。

华为 ADS3.0「端到端」的实际表现:从一个车位智驾到另一个车位

不看广告,看疗效。

「端到端」的 ADS3.0 在路上开起来会有怎样的表现,应该才是用户们最为关心的事情。在实际的应用层面上,华为 ADS 3.0 实现了 「从车位到车位」的物理端到端。

在稍早前,我们提前试驾了首发搭载华为 ADS3.0 的享界 S9。得益于「端到端」的仿生神经网络模型,享界 S9 在「全国都能开」的基础上,获得了车位启动、路边启动、路边临停、目的地随时变更、自主过闸机等一系列智驾能力的升级,力求做到用智能辅助驾驶来贯通全场景,实现「有路就能开」。

官方规划的试驾路线也比较有趣,我们从苏州四季酒店的地库直接出发,目的地是太湖万丽酒店的地库,全程超过了 40 公里,耗时大约 1 个小时。

因为两地的地下停车场都已经被扫描过,都可以被导航识别为「常用车位」了,所以我们可以在四季酒店地库的静止停车位上,设定好到万丽酒店地库车位的导航,然后直接点下方向盘上的智驾按钮,享界 S9 就会智驾泊出车位,自己开出四季酒店的地库。

即便四季酒店的地库出入口是一个很窄的直角弯,但也没有难倒享界 S9,它自己紧贴着墙就熟练地开出去了。识别闸机也能做到自动减速,等抬杆之后再加速驶出。

酒店园区内的道路本来没有在导航地图上显示,但享界 S9 的环境感知和决策能力都有升级,不仅可以避让快递车辆,也能避让临时设立的障碍物。

面对环岛也很从容,以较快的车速就完成了绕环岛通行,方向盘也打得很迅猛。

以往需要接管的掉头场景,现在用 ADS3.0 也无需接管,智驾将方向盘丝滑一打,掉头弯就过去了。

识别红绿灯的感觉也变得更加敏锐,在绿灯闪烁的时候,车辆就已经捕捉到了,提前进行了预判并且自动地实现了舒缓减速,稳稳地停在红灯之前。

在面对一些复杂场景时,ADS 3.0 端到端的优势就体现出来了。在一个需要走最右侧车道的场景里,所需车道被占用,而且道路划线不清晰的情况下,享界 S9 很果断就取消了变道,选择了加速绕行,丝滑程度堪比真人老司机一样提前做了预判。

在高速路上,享界 S9 现在在上下匝道的时候也无需接管了,即便是连续变道也能快速响应。

唯一的缺点,就是变道一如既往地积极,即便是在标准状态下,我感觉有很多时候其实它都不需要特意变道的,变道过去还是得变道回来。考虑到享界 S9 的后排经常坐着老板,这样子的变道体验,应该会受到老板们的批评吧?

也许,享界 S9 可以考虑出一版不那么激进变道,稳妥驾驶的智驾特调版本?目前想要缓解这个情况,我们可以试着将 NCA 的变道偏好默认设置为「柔和」,这样它会降低变道超车的频率,也可以考虑将智驾的变道策略改成人工确认。但这样,就不太能实现完全零接管的智驾表现了。

最终,我们顺利抵达了导航目的地万丽酒店的门口,然后享界 S9 紧接着无缝地自动驶入了地下车库,并且自己找到了目标车位并自行泊入。在全程 NCA 且完全零接管的情况下,实现了从车位到车位的端到端智驾。

用车位到车位的这种物理端到端表现来衡量端到端智驾的含金量,我觉得是比较易于理解也比较全面的。

有了「端到端」模型加持,ADS 3.0 的智驾表现更加符合我们对智能驾驶的主观想象,它开起来更像人类司机,通行效率也有了长足的进步。

此时,若是余总再说一遍「(华为 ADS)无限接近于 L3」的话,质疑声音也应该会少了许多。

华为 ADS 3.0「端到端」的技术路线,有何不同?

在华为 ADS 2.0 智驾解决方案中,华为提出了基于激光融合的 GOD 网络,配合 RCR 道路拓扑推理网络来实现「有图无图都能开」的智驾表现,让车辆能够自行识别真实世界的通用障碍物,基本做到类人的感知能力,最终量产实现「全国都能开」的无图 NCA 智驾能力。

▲ 华为 ADS 2.0 BEV+GOD+RCR 网络

其中,GOD 网络(General Obstacle Detection,通用障碍物检测网络)可以通过激光雷达+摄像头,来识别通用障碍物白名单外的异形物体,像游戏《我的世界》那样,用 3D 像素块来构建出障碍物的轮廓,从而对路上的障碍物进行精细识别,不但能够识别障碍物的动静态,而且也能匹配区分出救护车、警车、行人等等。

▲ GOD 感知算法示意(图片来自:华为官网)

有了 GOD 网络,智驾系统对路上障碍物的识别不再存在上限,真正地做到了 「看得懂物」。

▲ 异形障碍物「世界」(图片来自:华为官网)

而 RCR 网络(Road Cognition & Reasoning,道路拓扑推理网络)是为了进一步让智驾摆脱高精地图的依赖,结合普通导航地图来与现实进行匹配和印证,再实时通过传感器来拓补绘制一幅可用的行车地图。

有了 RCR 网络,智驾系统能够做到「具体路况具体分析」,真正地做到了 「看得懂路」。

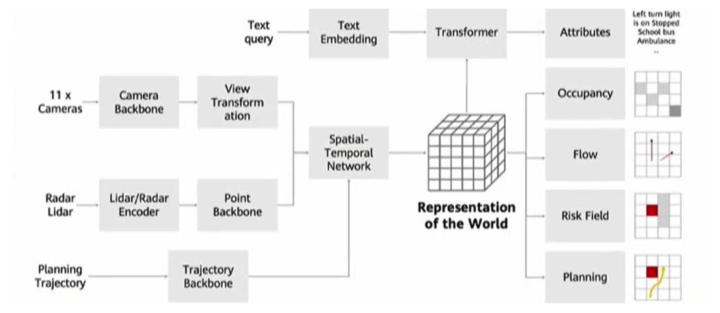

可见,以往的智驾都是基于「感知 — 规划(决策)— 控制」的研发逻辑,就是将感知数据传输到规控进行匹配识别,再输出控制指令来操控车辆驾驶。

如果传感器感知到的「这道题」(路况信息)是题库里面有做过的(训练过的特征信息),那么控制端就能给出一个「正确答案」(正确的决策方案),让车辆完美地应对好当前的路况。

毕竟道路千万条,安全第一条。路面状况瞬息万变,遇到一些未曾训练好的场景,智驾系统就会手足无措,只能提示人类驾驶者去接管车辆了。

要想提升智驾的控制表现能力,让智驾能像人类一样开车,就需要智驾系统能够像人类一样思考。

由此,智能驾驶开始引入了像 ChatGPT 这样,基于庞大神经网络而构建的大语言模型,智驾系统直接由一个「端到端模型」来全流程地处理从传感器接收到的感知数据,并完成判断和决策,最终输出控制指令。

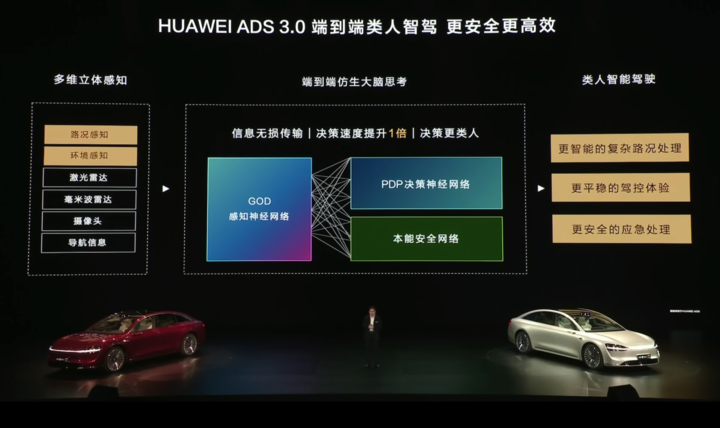

在 ADS 3.0 当中,华为将 GOD 和 RCR 都神经网络化,并将这部分算法纳入到一个完整的 GOD 感知神经网络之中,而后再将感知数据交由 PDP 决策神经网络来规划行车路线,输出「思考」结果。

构建好的 GOD+PDP 神经网络模型之后,华为再利用自己的云端 AI 训练平台进行大量的数据训练,让模型得以快速迭代升级。

ADS3.0 提升了 GOD 大网的多维立体感知能力并使用「端到端」决策的 PDP 之后,就能实现去 BEV 化,从原来的「看得懂物」升级到「看得懂路」,让智驾系统更高效且精准地「理解驾驶场景」,以低延时的决策速度,自主地处理好复杂路况,更多时候会给用户带来一种平稳、放心、无需接管的智驾体验。

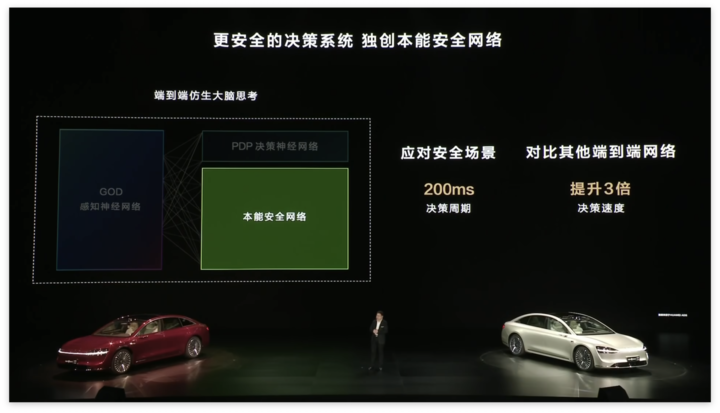

只不过按照目前的初见成效的训练效果来说,让 AI 直接坐在驾驶位去开车,还是过于激进。目前华为的端到端模型之中,还加入了一个 「本能安全网络」进行智驾的下限兜底,确保决策神经网络不会逾越安全红线。

吴新宙曾经提到,端到端将在长期与传统自动驾驶堆栈并行运行,最初端到端模型将在影子模式下运行,以便在相同的场景下比较人类驾驶、传统堆栈和端到端算法三者输出的行为差异,并根据人类反馈进行微调;之后端到端可以和传统技术堆栈并行,两者形成互补;成熟之后则可以逐步淘汰传统堆栈。

端到端算法像襁褓里的天才少年,尽管未来可能成为博士,但成长过程中需要小学、初中老师去带教,这便是当前传统堆栈起到的作用,随着时间的推移,端到端将最终成长成为强大的可以独挡一面的「专家」。

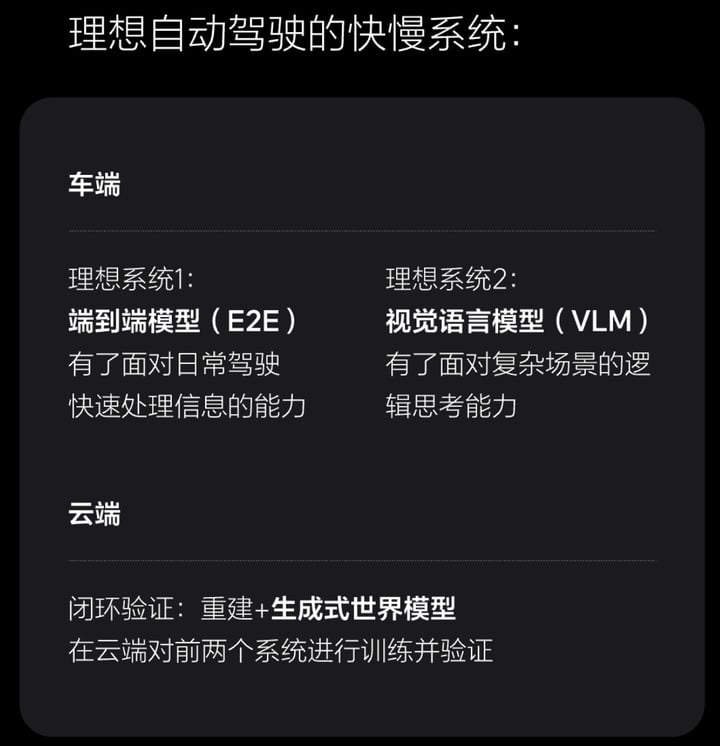

所以,无论是华为 ADS3.0 的端到端仿生大脑,还是理想 AD 的快/慢系统,以及小鹏的 Xnet+Xbrain+Xplanner 架构,都在端到端决策和车辆控制之间,做了相当多的约束和冗余措施。

普遍来看,当下端到端智驾的目的,就是为了简化智驾系统架构,通过单一的神经网络模型来完成整个智驾系统的感知和决策任务,减少对海量场景规则代码的依赖,从而提升智驾的实际效果,满足用户真正的智驾需求。

换作是之前的智驾策略,别说从一个车位到另一个车位的智驾零接管,单拎绕环岛通行和掉头场景来说,智驾甚少能够正常自主行驶的,大多数时候都得提醒人类驾驶员去接管行驶。

简单来说,结合 ADS 3.0 端到端的实际体验来看,用大模型来将智驾变得更类人化。从全国都能开,升级到有路就能开。

大势所趋的端到端智驾,车企争先恐后迎头而上

中国汽车在电动化和智能化方面的一日千里,正在重塑消费者对汽车的偏好与选择。其中,智驾已成为新能源汽车智能化的显著特征,消费者对于汽车智驾的了解程度、价值感知正日益提升。

消费市场的需求选择,也反过来促使车企更加紧密地拥抱电动化和智能化,唯有做好智能座舱和智能驾驶,才能在智能化的下半场站稳脚跟。

所以,那些在智驾方面竞争优势不太突出的车企,正在使出浑身解数,试图补齐智驾短板。

就像近期饱受争议的极氪,在 2024 款极氪 001 上市数月之后,马上就迫不及待推出了 2025 款车型,新款计算平台由双 Mobileye EyeQ5H 升级到了双英伟达 OrinX。两者相比之下,24 款只有 48Tops 的算力, 25 款的算力则达到了 508Tops,足足强了十倍。

虽然此举引发了不少老车主的不满,但对于极氪来说却是不得已而为之。

按照极氪的回应,此时就推出 2025 款极氪 001,是为了满足更多的潜在用户:

极氪 007 搭载的浩瀚智驾受到了广泛的用户和行业好评,很多极氪 001 的潜在用户呼吁能够选择浩瀚智驾方案,同时我们自己的品牌 NPS(Net Promoter Score,净推荐值)调研也发现,智驾是影响用户选择极氪 001 的一个因素。因此,内部决策立项自研智驾方案上车,给用户多一种选择。

相较于 Mobileye 的智驾方案,自研的浩瀚智驾方案显然能够在智驾体验上挽回一些用户口碑,只是恐怕切换成自研智驾还是来得太晚,加上这样的换代更新频率,势必会从保值的角度影响到潜在用户的信心。

正当成绩偏科的同学在决心勤能补拙,而排名靠前的优等生们已经开始研读新学期的课题了。

对于那些已经将「智驾」做成品牌显著标签的车企,像是鸿蒙智行、小鹏、理想等等,都已经量产推送了「全国都能开」的无图智驾,现在更是着手布局端到端的大模型智驾方案。

他们都有一个相近的目标,就是完全覆盖用户从出门到进门之间的通勤,完全交给 AI 智驾来开车。与循规蹈矩的传统智驾方案相比,端到端的智驾方案,将推动智驾从算法工程转变为数据工程。

要坐到端到端智驾的牌桌上,需要足够多的筹码

从 ADS1.0 迭代到 ADS2.0 的时候,华为 ADS 团队就曾经披露过他们全栈自研的 AI 训练体系。

构建智驾大模型最坚实的基础和底气,来自于华为拥有自己的云端 AI 训练平台。彼时他们就已经用领先于大多数同行的超高算力,24 小时不间断地进行模型训练,实现了五天迭代一次的升级速度。

来到 ADS3.0 的端到端,学习训练的算力已经从半年前公布的 3.5E FLOPS 更新到 5E FLOPS(余总还说 3.5E 算力当时已经是中国第二名和第三名的总和),模型每天训练的里程数达到了 3500 万公里。而且这个算力数字对于华为 ADS 来说并非一个终点,而是会继续去加大投入,持续提升。

随着智能驾驶步入深水区,智驾 AI 大模型的训练离不开海量的、多样化的优质数据,同时自动化、高水平的数据处理体系也至关重要。可以说数据,将会占据端到端智驾开发中高达八成的研发成本。

正如大语言模型之前已经强调过参数量之大那样,端到端的多模态模型也对数据有着旺盛需求。特斯拉在 FSD V12 上率先实用了端到端模型,马斯克曾经对此说过:

用 100 万个视频切片训练,勉强够用;200 万个,稍好一些;300 万个,就会感到 Wow(惊叹);1000 万个,那就难以置信了。

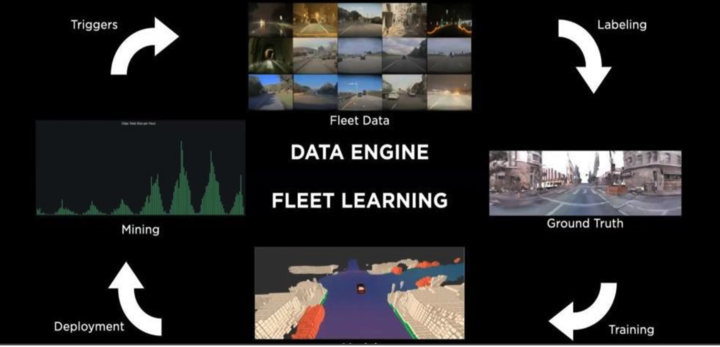

所以,车企量产的智能驾驶车辆正成为最佳的数据采集工具。当足够多的量产智驾车辆在道路上行驶时,它们所收集的真实数据将成为智驾算法不断优化和迭代的关键资源。

▲ Tesla Fleet. 图片来自:特斯拉北美官网

根据车企公布的数据,特斯拉在北美拥有约 300-400 万辆车组成的用户车队;预计到 2024 年年底,搭载华为智能驾驶系统的车辆数量将超过 50 万辆;截至 2024 年第一季度,理想已累计交付超过 70 万辆汽车,所有车型均标配 AD 智能驾驶功能;截止 2024 年 4 月份,蔚来智能驾驶总用户数达 49.53 万人,NOP+ 总用户数达 24.58 万人。

所以说,浩瀚的算力背后,是自研实力和充沛资金以及高额市占率的相辅相成。

华为 ADS3.0 的量产,足以证明一个可以量产商用的端到端智驾大模型,是需要掌握数据资源、充裕资金、技术积累的头部厂商,坚定正确的技术路线并付诸长期投入才能实现。

从这个角度来看,软硬实力一体构建起来的「端到端」智驾模型,将会成为智能驾驶的一道「AI 技术墙」。

有路就能开的端到端智驾,显然是智驾领域的新标杆,但在技术墙之外,其实仍有大量车企的车型,无法如期兑现全国都能开的智驾承诺。

最终能够下场「端到端智驾」牌桌竞争的玩家,非但需要前瞻的勇气,也需要足够多的筹码,短期内也只会有寥寥数家。